728x90

의사에게 배우는 '노코딩' 의료 데이터분석 with 바이브코딩 의 클로딩 프롬프트 정리한 글로 남긴 것으로 강의 듣다 보니 다소 놓친 부분이 많습니다. 감안하고 봐주세요.

클로드 : > 폴더내 파일은 바이브코딩-의료료 데이터 분석 강의헤서 사용했던

클로드 프롬트프입니다. 순번, 내용 및 강의시간을 표시했는데 맞는지

분석하고 블로그에 글을 올릴 수 있도록 데이터 정리해줘요. '

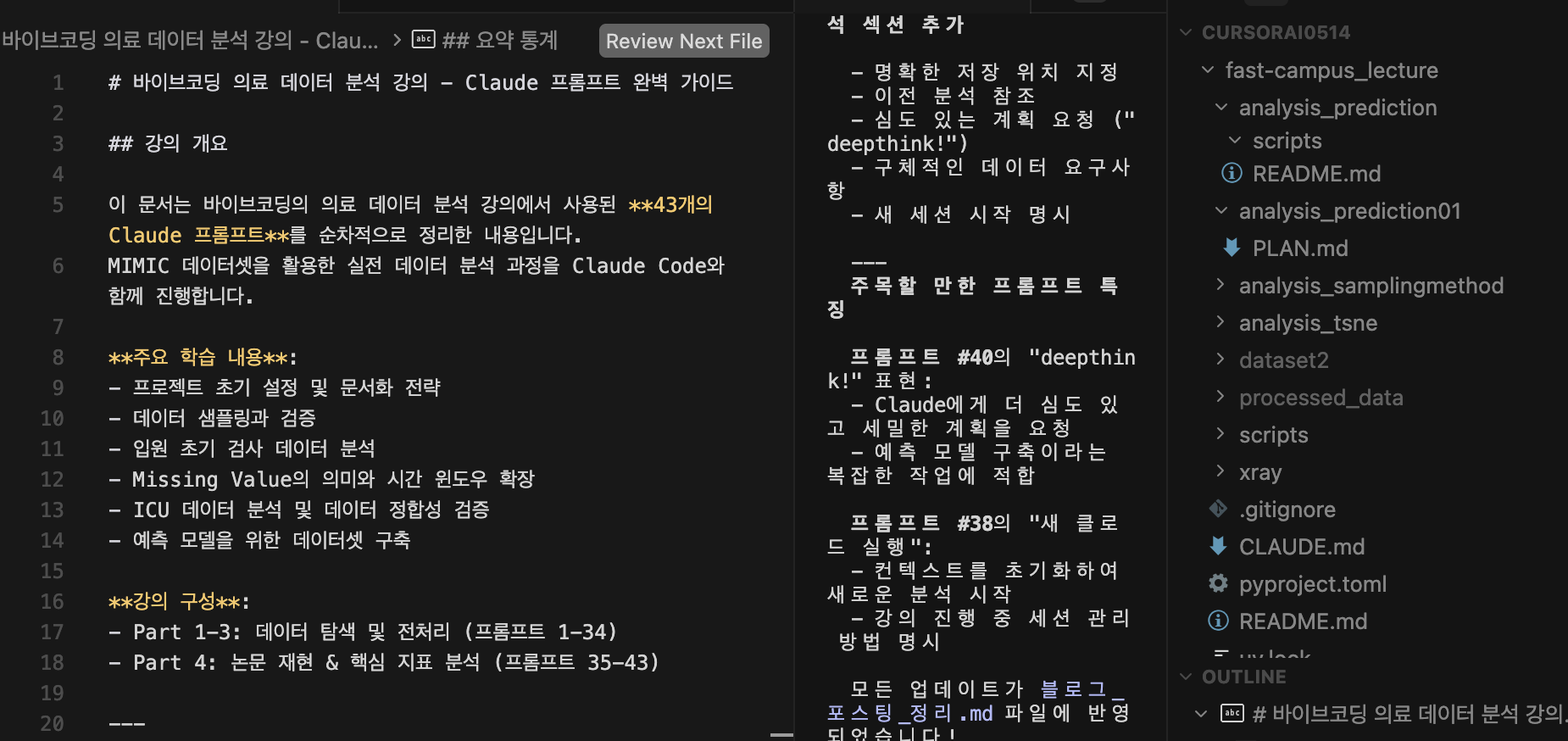

# 바이브코딩 의료 데이터 분석 강의 - Claude 프롬프트 완벽 가이드

## 강의 개요

이 문서는 바이브코딩의 의료 데이터 분석 강의에서 사용된 **75개의 Claude 프롬프트**를 순차적으로 정리한 내용입니다.

MIMIC 데이터셋을 활용한 실전 데이터 분석 과정을 Claude Code와 GPT API와 함께 진행하며, AI의 오류를 발견하고 수정하는 과정까지 다룹니다.

**주요 학습 내용**:

- 프로젝트 초기 설정 및 문서화 전략

- 데이터 샘플링과 검증

- 입원 초기 검사 데이터 분석

- Missing Value의 의미와 시간 윈도우 확장

- ICU 데이터 분석 및 데이터 정합성 검증

- 예측 모델을 위한 데이터셋 구축

- 머신러닝 모델 개발 (사망률 & 입원기간 예측)

- t-SNE 군집 분석

- GPT API를 활용한 비정형 의료 텍스트 처리

- **AI 오류 디버깅 및 데이터 손실 방지** (NEW!)

**강의 구성**:

- Part 1-3: 데이터 탐색 및 전처리 (프롬프트 1-34)

- Part 4: 논문 재현 & 핵심 지표 분석 (프롬프트 35-58)

- Part 5: GPT API를 이용한 비정형 데이터 구조화 (프롬프트 59-61)

- Part 6: Claude Code의 약점을 보완하자 (프롬프트 65-75)

---

## Part 1: 프로젝트 초기 설정 및 데이터 탐색

### 프롬프트 #1: UV 패키지 관리 설정

```

uv로 패키지 관리를 하려고 한다. 이 프로젝트에서 진행을 할 거고,

uv.lock을 통해서 패키지 버전 관리를 한다.

```

**목적**: 프로젝트의 패키지 의존성 관리 체계 수립

---

### 프롬프트 #2: MIMIC 데이터셋 탐색 계획

```

지금 이 폴더에서는 mimic data에 대해서 분석을 하려고 한다.

그런데 지금 claude code를 한 번도 실행을 안 시켜서 기본적인 내용이 없다.

추후에 이와 같은 내용에 대해서 결정짓고, 기본적으로는 dataset2에 보면

core에 있는 데이터가 있는데 여기 이 파일들이 어떤 의미인지를 파악해야 된다.

데이터 분석을 시행하고, 만약 파일이 너무 크면 10000줄 정도만 불러서 파악을 한다.

그래서 나한테 알려줘.

```

**목적**: dataset2/core 데이터 파일 탐색 및 구조 파악

---

### 프롬프트 #3: 문서화 규칙 수립

```

claude.md로 지금 내용을 작성해야 되는데, 중요하게 있다.

앞으로는 모든 내용을 진행할 때 뭔가 설명을 해야 되면 md 파일로 저장을 해야 한다.

그리고 md 파일로 저장을 할 때는 각 py 파일이나 아니면 png 파일을 볼 수 있게 해야 하고

반드시 참조를 걸어야 한다. 특히 코드 같은 경우는 어떤 라인의 몇 번째 줄에서 실행한 것인지를 기술한다.

그래서 독자가 프로그래밍에 대한 이해도가 떨어져도 진행할 수 있게 해야 한다.

폴더 구조는 반드시 잡아야 하고 각 분석별로 혹은 정리별로 md 파일과 py 파일은 구분되게

폴더 구조를 잡아야 한다. 이걸 기억해야 되니 이해하기 좋게 만들어 봐.

```

**목적**:

- MD 파일 중심 문서화 체계 구축

- 파일 참조 및 라인 번호 명시 규칙

- 초보자도 이해 가능한 문서화

---

### 프롬프트 #4: 분석별 폴더 구조 재설계

```

아니 분석별로 폴더 구조가 나와야 한다.

지금은 모든 md 따로, py 따로인데, 매 분석의 종류마다 폴더 구조 달라야 한다.

예를 들어서 analysis_missing이라고 하면 해당 폴더에 관련된 파일들이 구분되어야 하고,

분석이 달라지면 analysis_{something}과 같은 새로운 분석 구조를 만들어서 보여줘야 된다.

```

**목적**: `analysis_{name}` 형태의 분석별 독립적 폴더 구조 설계

---

### 프롬프트 #5: 추가 데이터셋 분석

```

마찬가지의 방법으로 추가 분석을 해야 되는데, dataset2에 있는 나머지 폴더에 대해서도

비슷하게 내용을 봐야 되고 너무 복잡하게 하지 말고, 모든 테이블당 1만 건의 row를 확인해서

내용과 컬럼 위주의 설명, 그리고 해당 데이터 내에서만 일단 분석을 해줘.

그리고 이 내용은 마찬가지로 md로 만들어주고 아까와 다른 md 파일로 만든다.

```

**목적**: dataset2 전체 폴더 탐색 (각 테이블 1만 건 샘플링)

---

### 프롬프트 #6: Claude 세션 재개

```

방금 전 세션을 종료한 뒤 claude --resume으로 이전 대화 목록을 띄워서,

방금까지 작업하던 세션을 다시 선택해 재개한 상태에서 위의 프롬프트들을 계속해서 실행한다.

```

**추가 정보**: 이미지 없이 프롬프트만 사용, Claude 세션 재개 방법 설명

---

## Part 2: Ch03-03. 코드 분석 중 오류 재검토 및 claude.md 재정리하기

### 프롬프트 #7 (타임코드 미기재)

```

claude.md를 보고 내용을 잘 이해한 뒤에 내용을 진행한다.

마찬가지의 방법으로 추가 분석을 해야 되는데, dataset2에 있는 나머지 폴더에 대해서도

비슷하게 내용을 봐야 되고 너무 복잡하게 하지 말고 모든 테이블당 1만 건의 row를 확인해서

내용과 컬럼 위주의 설명, 그리고 해당 데이터 내에서만 일단 분석을 해줘.

그리고 이 내용은 마찬가지로 md로 만들어주고 아까와 다른 md 파일로 만든다.

```

---

### 프롬프트 #8 (타임코드 미기재)

```

claude md 파일에 보면 파일 구조가 좀 독특한데, processed_data에 보면

figure, scripts, md 파일이 갖는 구조를 보고 나머지도 그렇게 해줬으면 좋겠다.

```

**목적**: processed_data 폴더 구조 통일화

---

### 프롬프트 #9 (타임코드 미기재)

```

service_transitions = services_df.sort_values(['subject_id', 'transfertime'])로 정렬한 다음,

service_transitions['prev_service'] = service_transitions.groupby('subject_id')['curr_service'].shift(1)

이렇게 코드를 짜놨는데, 이렇게 보는데 이게 무슨 말이야? 쉽게 알려줘.

```

**목적**: pandas shift() 함수 이해

---

### 프롬프트 #10 (타임코드 미기재)

```

그러면 지금 데이터에서 저 함수가

service_transitions = services_df.sort_values(['subject_id', 'transfertime']),

service_transitions['prev_service'] = service_transitions.groupby('subject_id')['curr_service'].shift(1)

여기서 shift가 들어간 이유는 뭐야?

```

**목적**: shift() 함수 사용 이유 이해

---

### 프롬프트 #11 (타임코드 미기재)

```

@analysis_comprehensive/README.md 여기서 분석을 보면 5만 건만 분석을 하고,

@analysis_comprehensive/comprehensive_analysis_report.md 여기서 보면

환자의 5만 건 입원 기록을 보고 있다고 했다.

상식적으로 데이터의 개수가 지금 건수와 다른데, 이게 맞는지 보고

처음부터 5만 건만 읽어서 이런 분석이 나온 건 아닌지 곰곰이 생각하고,

이에 대해서 테스트하는 방법을 고민해 봐.

```

**목적**: 샘플링 방식 검증 (5만 건 vs 전체 데이터)

---

### 프롬프트 #12 (타임코드 미기재)

```

지난 문제는 이 샘플링의 검증 결과 보고서에서 5만 개를 읽고 나서 분석을 하니

전체의 분석이 틀린 것으로 보인다.

그래서 지금 @analysis_comprehensive/ 안에 있는 내용을 변경할 예정인데,

이는 core 테이블에 있는 내용을 샘플링이 아니라 전체 파일을 읽어서 해석을 하는 것으로 한다.

기존의 내용은 5만 개만 읽어서 한 것으로 보이거나 그보다 작게 해서 분석을 한 것으로 보이는데

이는 전부 잘못된 내용이므로 이를 다시 분석해야 한다.

```

**목적**: 샘플링 오류 발견 및 전체 데이터 재분석

---

### 프롬프트 #13 (타임코드 미기재)

```

지금 claude.md 파일에 보니 이 내용은 전부 uv로 패키지 관리를 하고

이걸로 실행하는데 관련 내용이 없는 것 같다.

이 내용 추가해서 앞으로 항상 이렇게 진행하게 해줘.

```

**목적**: claude.md에 uv 패키지 관리 내용 추가

---

### 프롬프트 #14 (타임코드 미기재)

```

[Ch03-03. 코드 분석 중 오류 재검토 및 claude.md 재정리하기] 라는 강의 챕터에서

사용할 프롬프트로, 위 1–13번 내용 전체를 순서대로 수행하면서

코드·샘플링 오류를 재검토하고 claude.md 구조와 내용을 다시 정리하도록 한다.

```

**추가 정보**: 강의 챕터 정보 추가 요청

---

### 프롬프트 #15: 폴더 구조 정의 (19:46)

```

그러면 지금 폴더의 내용을 보고 데이터가 2개가 있다.

dataset2는 전체 데이터셋을 의미하고, processed_data에는 앞으로 processing을 해서

들어갈 것들을 말한다. 이 내용을 폴더 구조로 기억해서 진행해 줘. claude.md에 포함한다.

```

**폴더 구조**:

- `dataset2`: 원본 전체 데이터셋

- `processed_data`: 전처리된 데이터 저장소

---

### 프롬프트 #16: Demographic Analysis 계획 (타임코드 미기재)

```

그러면 기본 분석으로 진행을 할 건데, analysis로 patients, admission 테이블을 기준으로 해서

전체 사망 및 연령별 사망률 그리고 sampling을 하려고 하는데 어떻게 하는 게 적절한지

기초적인 지식을 제공할 수 있게 demographic analysis를 진행한다.

```

**강의 챕터**: Part 3. Claude Code 실전 : 데이터 품질 점검 및 전처리

Ch01-01. Data Sampling 하기 (12:37)

---

### 프롬프트 #17: analysis_basic 삭제 (34:18)

```

방금 내용 중 analysis_basic을 지웠다.

이걸 참고하고 있는 다른 내용이 있으면 관련 내용을 수정해서 없애졌다는 것을 고려하고,

claude.md를 수정한다.

```

---

## Part 3: 데이터 품질 점검 및 전처리

### Ch01-01. Data Sampling 하기

#### 프롬프트 #18: 샘플링 계획 수립 (12:37)

```

그러면 나는 이런 샘플링 계획을 세우겠다.

샘플링은 admissions.csv를 기준으로 한다. 그리고 나머지 내용은 그에 따라서 반독을 한다.

sampling이 된 데이터는 processed_data에 담고, 폴더 구조는 dataset2와 같다.

0세는 제외한다.

사망자는 병원 내 사망자가 있는 admission 데이터로 300건,

병원 이후 사망자가 있는 데이터로 300건,

그리고 사망하지 않은 데이터로 600건을 해서 총 1200건의 데이터를 추출한다.

이를 바탕으로 나머지 내용을 진행할 예정인데, 랜덤하게 추출하고,

추출 방식에 대해서 상세하게 기입해야 한다.

이는 analysis_samplingmethod에 저장한다.

```

**샘플링 전략**:

- 기준 테이블: admissions.csv

- 병원 내 사망자: 300건

- 병원 이후 사망자: 300건

- 생존자: 600건

- **총 1,200건**

- 0세 제외

- 저장 위치: `analysis_samplingmethod`

---

### Ch01-02. Data Filtering으로 Subset 만들기

#### 프롬프트 #19: 샘플링 메소드 확인 (0:29)

```

샘플링 메소드를 다시 한 번 읽고, 내용을 간단하게 확인해 봐.

```

---

#### 프롬프트 #20: hosp 데이터 추출 계획 (1:26)

```

이 내용을 바탕으로 해서 hosp에 있는 내용을 추출하려고 한다.

전체는 아니고, 반드시 해야 하는 건 diagnosis, drgcodes, labevents, microbiology, service를 뽑고

환자 데이터가 아니라 전반적인 데이터셋에 필요한 건 processed_data에 넣어야 한다.

이를 바탕으로 계획을 세워 봐.

```

**추출 대상 hosp 데이터**:

- diagnosis

- drgcodes

- labevents

- microbiology

- service

---

#### 프롬프트 #21: 실행 코드 파일 확인 (13:13)

```

오케이 그러면 지금 실제로 실행된 코드가

@analysis_samplingmethod/scripts/analysis/ 중에서 어떤 거야?

그리고 extract 관련 파일이 3개가 있는데 이건 전부 필요한 거야?

실제로 쓴 것만 기록하고, md 파일에 어떤 파일로 진행한 건지도 기록해야 돼.

```

**목적**: 실제 사용된 코드 파일 정리 및 MD 문서화

---

### Ch02-01. 숨겨진 데이터 찾기 - 그래프화 및 평가

#### 프롬프트 #22: 가장 흔한 혈액검사 확인 (7:55)

```

좋아서 그러면 여기서 가장 기본으로 분석할 내용을 만든다.

analysis_initial_lab이란 데에 폴더를 만들고 다음을 진행한다.

입원이벤트를 기준으로 해서 입원 월에 시행한, 즉 입원한 당일에 시행한 혈액검사 결과를 가져와야 한다.

그런데 지금 어떤 혈액검사를 가져와야 할지 모르겠다.

가장 흔하게 시행하는 혈액검사를 가져오고 싶은데, 이에 대한 기본적인 내용을 확인하려면 어떻게 해야 하지?

```

---

#### 프롬프트 #23: d_labitems_inclusion.csv 확인 (9:51)

```

일단 @processed_data/hosp/d_labitems_inclusion.csv 여기서 inclusion에 포함된 내용은

내가 앞으로 추출할 혈액검사 명단이다.

이를 알아야 하니 일단 이에 대해서 내용을 확인해 봐.

```

---

#### 프롬프트 #24: analysis_initial_lab 데이터 병합 계획 (11:07)

```

오케이 그럼 이 내용을 바탕으로 해서 지금 analysis_initial_lab에 다음을 분석할 예정이다.

1. 입원이벤트를 바탕으로 해서 데이터를 준비한다. 입원이벤트는 데이터가 없다고 해서 지워지거나 해서는 안 된다.

2. 위의 혈액검사 전부를 다 가져온다.

3. 입원을 기준으로 해서 데이터를 병합한다.

4. 데이터가 없으면 없는 채로 둔다.

이에 대해서 계획을 세워 봐.

```

**분석 계획**:

1. 입원이벤트 기준 데이터 준비 (누락 데이터 유지)

2. 전체 혈액검사 데이터 추출

3. 입원 기준 데이터 병합

4. 결측치 유지

---

#### 프롬프트 #25: 입원일 기준 변경 (13:27)

```

입원일로부터 24시간 이내가 아니라 입원일 자체로 한다.

분, 시는 버리고 입원일자로 해서 계산한다.

```

**변경사항**: 24시간 이내 → 입원일자 기준 (분/시 제외)

---

#### 프롬프트 #26: lab availability matrix 제외 (14:24)

```

lab availability matrix는 필요하지 않다.

나머지 내용은 좋으니 이에 대해서 진행한다.

```

---

#### 프롬프트 #27: "입원 시 혈액검사 시행" 정의 (20:04)

```

그러면 여기서는 입원에 대해서 검사 시행 현황,

4277개 입원(35.6%)에서 입원 당일 혈액검사 시행,

입원당 평균 17.1개 검사 항목 측정 이런 내용이 있는데,

여기서 입원 시 혈액검사를 시행했다는 것의 정의는 뭐야?

이 내용도 추가되어야 될 것 같은데, 지금 시행한 코드를 기준으로 설명해 봐.

```

---

#### 프롬프트 #28: 검사 시행 판단 기준 (22:51)

```

그러면 저 여러 가지 검사 중에서 한 가지만이라도 입원일에 검사를 했으면 했다고 평가하는 건가?

```

**정의**: 여러 검사 항목 중 하나라도 입원일에 시행하면 "입원 시 혈액검사 시행"으로 판단

---

#### 프롬프트 #29: 입원 당일 데이터 부족 판단 (29:42)

```

좋았다 그러면 지금 입원 당일에 했을 때는 데이터가 부족하다고 판단이 된다.

그리고 지금 네가 작업한 @analysis_initial_lab/data/admission_day_labs.csv을 만드는 과정들은

현재 랩이 실행된 사람들만을 기준으로 하고 있기 때문에 missing value들을 평가하는 데 상당히 제한되는 것 같다.

그래서 이건 잘못된 분석이라는 내용들을 readme에 추가하고, 다음의 내용을 진행해야 한다.

```

**목적**:

- 입원 당일 데이터만으로는 missing value 평가가 제한적임을 발견

- 분석 방법의 한계를 README에 명시

---

#### 프롬프트 #30: 시간 윈도우 확장 계획 (30:30)

```

좋았다 그러면 지금 입원 당일에 했을 때는 데이터가 부족하다고 판단이 된다.

그리고 지금 네가 작업한 @analysis_initial_lab/data/admission_day_labs.csv을 만드는 과정들은

현재 랩이 실행된 사람들만을 기준으로 하고 있기 때문에 missing value들을 평가하는 데 상당히 제한되는 것 같다.

그래서 이건 잘못된 분석이라는 내용들을 readme에 추가하고, 다음의 내용을 진행해야 한다.

1. 입원이벤트를 바탕으로 해서 데이터를 준비한다. 입원이벤트는 데이터가 없다고 해서 지워지거나 해서는 안 된다.

2. 위의 혈액검사 전부를 다 가져온다.

3. 입원일 기준으로 해서 데이터를 전후 1일, 즉 입원 전날, 입원 다음날까지 해서 missing value를 채워준다.

4. missing value가 발생했을 때 입원 당일에 혈액검사가 없으면 입원 전날, 그리고 그다음엔 입원 다음날 데이터를 가져며,

이 순서대로 missing value를 채워 넣는다.

5. 이후에 추분석을 할 예정인데, 입원 당일에 갖는 missing value들의 분포와

입원 전후 1일차를 전부 데이터를 채워 넣었을 때 missing value가 갖는 의미를 볼 것이다.

```

**Missing Value 채우기 전략**:

1. 입원이벤트 기준 데이터 준비 (누락 데이터 유지)

2. 전체 혈액검사 데이터 추출

3. 시간 윈도우: 입원 전날 ~ 입원 다음날 (±1일)

4. 우선순위: 입원 당일 → 입원 전날 → 입원 다음날

5. 비교 분석: 입원 당일 only vs 전후 1일 포함

---

### Ch03-01. Time Window로 Missing Value의 진짜 의미 재평가

#### 프롬프트 #31: Missing Value Analysis 진행 (7:25)

```

이에 대해서 missing_value analysis를 진행할 예정이다.

같은 폴더에 다른 md 파일을 만들어서 initial 입원일에 준해서 데이터를 모았을 때

실제로 missing value가 얼마나 발생하는지에 대해서 작성해야 한다.

```

**강의 챕터**: Part 3. Claude Code 실전 : 데이터 품질 점검 및 전처리

Chapter 3. 데이터 Pivot으로 입실 기준 환자 데이터 만들기

**목적**: 입원일 기준 missing value 발생 현황 분석

---

#### 프롬프트 #32: 문제 파일 명시 요청 (7:27)

```

잠깐 하기 전에 어떤 파일이 문제가 있는지도 같이 기술해야지,

그냥 분석법이 틀렸다고 하면 곤란해.

```

**목적**: 분석 방법의 한계를 명시할 때 구체적인 파일명 포함

---

#### 프롬프트 #33: 상위/하위 검사 항목 Availability 추가 (8:28)

```

이에 대해서 missing_value analysis를 진행할 예정이다.

같은 폴더에 다른 md 파일을 만들어서 initial 입원일에 준해서 데이터를 모았을 때

실제로 missing value가 얼마나 발생하는지에 대해서 작성해야 한다.

지금 상위 10개에 대한 availability는 진행이 된 것 같은데, 하위 10개에 대한 availability는 없는 것 같다.

그래서 지금 총 포함하고 있는 검사 항목과 상위 10개 하위 10개의 missing value가 포함될 수 있도록

지금 검사 항목에 대해서 @analysis_initial_lab/initial_lab_analysis_report.md에 추가한다.

```

**추가 요구사항**:

- 총 검사 항목 수

- 상위 10개 검사 항목의 availability

- 하위 10개 검사 항목의 availability

---

#### 프롬프트 #34: 시간 윈도우 확장 구현 (13:15)

```

자 그러면 시간 윈도우를 확장하는 방법을 택해서 하나 더 파일을 만들 예정이다.

기준과 방법은 그대로인데, 입원 전일, 입원 당일, 입원 1일째의 데이터를 모두 합쳐서 데이터를 만든다.

합친다는 개념은, 입원 당일의 데이터가 있으면 그대로 가져오되,

없으면 입원 전일의 데이터, 그것도 없으면 입원 1일째의 데이터를 가져온다.

가져오는 방식과 랩의 포함 명목은 이전과 같다.

깊게 생각하고 플랜을 짜라.

```

**시간 윈도우 확장 로직**:

1. 시간 범위: 입원 전일(-1일) ~ 입원 1일째(+1일)

2. 우선순위 기반 데이터 병합:

- 1순위: 입원 당일 데이터

- 2순위: 입원 전일 데이터

- 3순위: 입원 1일째 데이터

3. 검사 항목 및 방법: 기존과 동일

4. **목적**: 시간 윈도우 확장으로 missing value 감소 효과 측정

---

## Part 4: MIMIC 실전 - 논문 재현 & 핵심 지표 분석

### Ch02-01. Claude Code로 ICU별 입원 기간 그리기

#### 프롬프트 #35: ICU별 재원기간 분석 계획 (4:30)

```

지금부터는 새로운 분석을 시작할 거야.

ICU별 재원기간을 그려보려고 한다.

이에 대해서는 새로 analysis를 만들어서 시행한다.

하기 전에 기초적으로 데이터 내용을 보고 어떻게 하면 좋을지 생각해 봐.

```

**강의 챕터**: Part 4. MIMIC 실전 : 논문 재현 & 핵심 지표 분석

Chapter 2. ICU Data 실제 분석하기

**목적**: ICU별 재원기간(입원 기간) 시각화

---

#### 프롬프트 #36: 샘플링된 ICU 데이터 필요성 확인 (5:38)

```

아니 지금 이 내용은 sampling된 한에서의 데이터가 아니네.

일단 ICU로 샘플링한 환자들의 데이터가 필요한데,

우리가 지금 수행하고자 하는 내용들을 고려하면 어떤 데이터들이 필요한지 생각해 봐.

```

**목적**: 샘플링된 환자 기준으로 필요한 ICU 데이터 파악

---

#### 프롬프트 #37: processed_data 저장 위치 명확화 (7:13)

```

processed_data는 바깥에 있는 내용으로 추가한다. 전체 내용이니까.

나머지는 현행과 같이 하면 될 것 같다.

```

**폴더 구조 규칙**:

- `processed_data`: 전체 데이터 관련 (프로젝트 루트 외부)

- `analysis_*`: 샘플링된 데이터 기준 분석

---

### Ch02-02. 서로 다른 사망자의 데이터 정합성 평가하기

#### 프롬프트 #38: 사망자 데이터 위치 확인 (3:34)

```

나는 이제 새로운 분석을 할 것이다.

여기서 보면 사망자 일자를 볼 수 있는데 현재 사망자 일자 및 사망이

병원 내, 병원 밖에서 죽은 사람들이 있다.

어느 데이터들에 이런 데이터가 있는지 확인해 봐.

```

**추가 정보**: 새 클로드 실행

**목적**: 병원 내/외 사망자 데이터가 어디에 있는지 확인

---

#### 프롬프트 #39: 사망 데이터 불일치 분석 (9:46)

```

그러면 이렇게 차이가 나는 사람들에 대해서 id를 뽑아서 정리해 줘.

그들의 특징 같은 게 있나?

```

**목적**:

- 병원 내/외 사망 데이터가 다른 환자 ID 추출

- 불일치 환자들의 특징 분석

---

### Ch03-01. MIMIC Dataset의 연결로 환자 Dataset 생성하기

#### 프롬프트 #40: 예측 모델용 데이터셋 생성 계획 (6:09)

```

이제 분석을 시작하려고 한다. 실제 분석이며 사망률 예측, 입원기간 예측을 하기 위한 데이터를 만들려고 해.

이걸 하기 위해서 @analysis_initial_lab_re/data/labs_initial_merged_wide.csv 이걸 가지고 만들 거야.

지금 사망은 붙어 있는데, 이게 입원기간 내 사망인지, 전체 사망인지 확인 및 구분이 필요하다.

이 두 가지에 대한 구분은 analysis_death01에 보면 있을 거야.

그리고 입원기간이 없는데 그것에 대해서도 붙여야 한다.

이는 analysis_prediction01라는 폴더에 저장을 해야 돼.

이걸 고려해서 아주 세심하고 심도 있게 계획을 짠다. deepthink!

```

**강의 챕터**: Part 4. MIMIC 실전 : 논문 재현 & 핵심 지표 분석

Chapter 3. MIMIC Dataset 기반 논문 따라하기

**분석 목표**:

- 사망률 예측 모델

- 입원기간 예측 모델

**데이터 요구사항**:

1. 기본 데이터: `labs_initial_merged_wide.csv`

2. 사망 구분: 입원기간 내 사망 vs 전체 사망 (from `analysis_death01`)

3. 입원기간 정보 추가

4. 저장 위치: `analysis_prediction01`

**프롬프트 특징**: "deepthink!" - 심도 있는 계획 요청

---

#### 프롬프트 #41: 나이 계산 방식 확인 (16:47)

```

오케이 그러면 지금 data에 있는 나이는 방금 만든 계산식으로 한 거야?

아니면 anchor_age야?

```

**목적**: 데이터셋의 나이 컬럼이 어떤 방식으로 계산되었는지 확인

- 계산식 기반 vs anchor_age 사용

---

#### 프롬프트 #42: Missing Value 기반 변수 선택 전략 (17:10)

```

오케이 좋았어. 그러면 이걸 가지고 예측 모델을 만들려고 한다.

그런데 지금 데이터가 지난번에 보니 missing value가 높은 게 많아서 적당히 선별하려고 한다.

어떤 방법이 좋을까?

```

**목적**: 예측 모델 구축 전 missing value가 높은 변수 선별 방법 모색

---

#### 프롬프트 #43: 기존 결측치 분석 참조 (17:26)

```

결측치 분석에 대해서는 @analysis_initial_lab/missing_value_analysis.md

여기에서 이미 분석이 되어 있다. 이거 보고 참고해.

```

**목적**: 이전에 수행한 결측치 분석 결과를 활용하여 변수 선택

**참조 파일**: `analysis_initial_lab/missing_value_analysis.md`

---

### Ch03-02. MIMIC Dataset 예측 모델로 사망, 입원 기간 예측하기

#### 프롬프트 #44: 폴더 구조 재구성 가이드 요청 (6:42)

```

오케이 좋았어, 그러면 각각의 분석에 대해서 진행을 해야 되는데

지금 폴더 구성이 별로라 헷갈릴 것 같다.

analysis_prediction들 내에 적절한 폴더 구조와 관련 파일 어떻게 생성해서 관리할지 가이드해 봐.

```

**목적**: analysis_prediction 폴더 내부의 체계적인 구조 설계

---

#### 프롬프트 #45: claude.md 업데이트 및 essential_dataset 시작 (9:33)

```

오케이 좋았어. 그럼 이 구조에 대해서 일단 이 폴더만 그런다는 걸

claude.md에 넣어줘, 그래야 나중에 폴더 구조 헷갈리지 않지.

그다음에, 지금 폴더 구조 현재 맞는지 본 뒤에 위 폴더 구조에 맞게 해서

essential_dataset부터 진행해 보자.

만약 중간에 확인이 안 되거나 분석 방법에 대해서 불분명한 게 있으면

반드시 나에게 보고하고 진행한다.

```

**중요 원칙**:

- 폴더 구조를 claude.md에 문서화

- 불확실한 사항은 사용자에게 보고 후 진행

---

#### 프롬프트 #46: 모델 개발 및 평가 전략 수립 (19:50)

```

베이스라인 개발하고, 그 이후 트리 모형으로 한다.

평가 지표는 사망 예측에 대해서 위에 내용 적절하다.

입원 기간 예측도 위의 내용이 적절하다.

교차 검증은 시간 기반 분할로 해서 한다.

과거와 최근으로 구분하고 7:3 정도로 나눠서 진행한다.

```

**모델링 전략**:

- **모델 순서**: 베이스라인 → 트리 모형

- **교차 검증**: 시간 기반 분할 (Time-based split)

- **분할 비율**: 과거 70% : 최근 30%

**이유**: 의료 데이터의 시간적 순서 고려 (과거 데이터로 학습 → 최근 데이터로 검증)

---

#### 프롬프트 #47: 한글 깨짐 문제 해결 (20:04)

```

지금 이 파일 보면 한글이 깨져 있다.

특히 그래프 그릴 때 이게 깨진다.

내용을 보고 보완하라.

```

**목적**: 한글 폰트 설정 문제 해결 (matplotlib 등)

---

#### 프롬프트 #48: Jupyter Notebook 실행 및 오류 수정 (32:38)

```

지금 만든 내용 2개의 ipynb가 있는데

실제 실행해 보고 오류가 있는 내용 수정한다.

```

**목적**: 노트북 파일 실행 검증 및 디버깅

---

#### 프롬프트 #49: nbconvert 설치 제안 (33:18)

```

아니 그냥 nbconvert를 설치해서 하는 게 더 나으면 그렇게 한다.

```

**목적**: 노트북 실행을 위한 도구 유연성 제공

---

#### 프롬프트 #50: 회귀 계수 해석 질문 (37:39)

```

Image #1 여기서 이 그림을 보면 coefficient가 나오는데,

이거 해석을 어떻게 해야 되는 거야?

```

**목적**: 회귀 모델의 coefficient(계수) 해석 방법 이해

---

#### 프롬프트 #51: 계수 해석의 모순 지적 (40:25)

```

Sodium, Glucose, Creatinine, Potassium: 전해질·대사 지표들이 정상일수록 입원 기간 감소.

근데 이건 지금 정상과 비정상으로 구분한 게 아닌데 어떻게 해석이 이렇게 되는 거야?

```

**목적**: 연속형 변수의 계수 해석 논리 확인

- 이분형(정상/비정상)이 아닌 연속형 변수의 해석 방법 명확화

---

### Ch03-04. 혈액검사를 통한 tSNE 분석 - MIMIC data 분류

#### 프롬프트 #52: t-SNE 분석 시작 (4:20)

```

이제 그 추가 comprehensive 등은 진행하지 않고, 다른 분석을 하려고 한다.

analysis_prediction과 같은 수준으로 해서 다른 폴더를 만든다.

analysis_tsne이다.

기본적으로 essential과 동일한 input을 갖는다.

t-SNE 분석으로 혈액검사·입원 과 특성, 성별 분포에 따른 군집을 보고,

사망 및 입원 기간과의 관련성을 본다.

```

**새로운 분석**: `analysis_tsne`

- **입력 데이터**: essential_dataset과 동일

- **분석 목적**:

- 혈액검사 결과 기반 군집 분석

- 입원 특성 및 성별 분포 시각화

- 사망 및 입원 기간과의 관련성 탐색

---

#### 프롬프트 #53: 분석 도구 변경 요청 (4:47)

```

아니 근데 분석하는 건 py로 하지 말고 ipynb로 해서 좀.

```

**도구 선택**: Python 스크립트(.py) → Jupyter Notebook(.ipynb)

---

#### 프롬프트 #54: 최신 버전 확인 (6:39)

```

지금 그래서 가장 최신 버전이 뭐야?

```

**목적**: 여러 버전 파일 중 최신 파일 확인

---

#### 프롬프트 #55: 불필요한 파일 정리 (6:55)

```

가장 최신 버전 잘 되는지 보고 다 확인되면 나머지 파일은 지운다.

안 쓰는 것들.

```

**목적**: 파일 버전 관리 및 정리

---

#### 프롬프트 #56: 코드 오류 수정 (13:14)

```

지금 위에서부터 시행하는데 여전히 문제가 생긴다.

그 위에 변수를 추가하거나 해야지.

```

**목적**: 노트북 실행 중 발생한 오류 해결 (변수 추가 등)

---

#### 프롬프트 #57: README.md 생성 요청 (13:26)

```

md 파일로 해서 전반적인 내용을 설명하는 내용을

readme.md에 담는다.

```

**목적**: 분석 내용 문서화

---

#### 프롬프트 #58: README.md 상세화 및 이미지 포함 (14:28)

```

오케이 그럼 이 전반적인 내용을 md 파일로 정리해야 되는데

readme.md에 넣어도 될 것 같다.

전반적인 내용을 다 담고 특히 사진은 다 넣어서 만들어 줘.

```

**문서화 요구사항**:

- 전반적인 분석 내용

- 모든 시각화 이미지 포함

---

## Part 5: GPT API를 이용한 비정형 데이터 구조화하기

### Ch01-01. GPT API를 이용하여 비정형 데이터 구조화하기

#### 프롬프트 #59: 코드 오류 원인 분석 (9:15)

```

지금 이걸로 dataset.iloc ['검사결과'] 이거는 잘 되었는데,

dataset.iloc ['검사결과'] 이 두 번째는 잘 안 된다.

이유를 잘 생각만 해봐. 코드는 고치지 말고.

```

**목적**: 코드 오류 원인 분석 (수정하지 않고 이해만)

---

#### 프롬프트 #60: 함수 교정 및 파일 추가 (9:42)

```

그럼 이걸 바탕으로 교정을 해야 한다.

교정한 함수를 지금 이 파일 맨 밑에 추가해서 넣어 줘.

```

**목적**: 오류 수정한 함수를 파일 끝에 추가

---

### Ch02-01. MIMIC-CXR dataset으로 보는 LLM API를 통한 정제 방법

#### 프롬프트 #61: GPT API 프롬프트 템플릿 (슬라이드 설명)

```

You are a helpful assistant that recognize specific disease (pneumonia, tuberculosis, interstitial lung disease)

from report as yes or no.

{report} 여기에 해당 리포트를 삽입.

Please format the extracted information in JSON as follows:

{

"pneumonia": "yes/no",

"tuberculosis": "yes/no",

"ILD": "yes/no"

}.

```

**목적**: 의료 리포트에서 질병 정보 추출을 위한 GPT API 프롬프트 설계

**추출 대상 질병**:

- Pneumonia (폐렴)

- Tuberculosis (결핵)

- ILD (Interstitial Lung Disease, 간질성 폐질환)

**출력 형식**: JSON (yes/no 형식)

---

## Part 6: Claude Code의 약점을 보완하자

### Ch01-02. 오류 수정하기 - Missing Value

#### 프롬프트 #65: Missing Value 데이터 불일치 발견 (1:56)

```

문제를 발견했다. 지금 initial_lab에 대한 분석을 미리 읽고,

원래는 @processed_data/hosp/d_labitems_inclusion.csv에 있는 1인건 모두 추출하는 걸로 되어 있어야 할 텐데,

지금 보면 @analysis_initial_lab/data/labs_time_window_wide.csv에 그 항목이 모두 있는 건 아닌 것 같고

offset이라는 게 등장한다.

이게 왜 발생하는 건지 지금까지 시행한 내용을 깊이 있게 보고 설명하고 이해해 봐.

```

**문제 상황**:

- 예상: d_labitems_inclusion.csv의 모든 항목 추출

- 실제: labs_time_window_wide.csv에 일부 항목만 존재, offset 등장

- **요청**: 심도 있는 원인 분석

---

#### 프롬프트 #66: 심도 있는 근본 원인 분석 (3:49)

```

그러면 실제로 원래 어떤 파일에서 분석했던 내용인지도 보고,

왜 문제가 생긴 것인지 심도 있게 판단해 봐. deepthink.

```

**키워드**: "deepthink" - 깊은 사고 요청

---

#### 프롬프트 #67: 45개 항목만 존재하는 이유 (10:44)

```

그런데 그렇게 해도 실제로 45개의 랩만 지금 @labs_improved_wide.csv에 있다.

왜 그런가?

```

**문제**: 기대한 항목 수와 실제 항목 수 불일치

---

#### 프롬프트 #68: 동일 label, 다른 itemid 처리 계획 (12:22)

```

그리고 실제로 같은 이름이라 제거했다고 하면,

실제로는 itemid가 다르지만 label은 같아서 이게 데이터가 달리 처리될 것 같은데,

이런 경우는 지금 어떻게 처리하고 있는지도 재평가가 필요하다.

이에 대한 내용도 plan에 짜서 다시 처리 기준을 만든다.

```

**핵심 이슈**:

- **같은 label** + **다른 itemid** = 서로 다른 검사

- 예: pCO2 (50818) vs pCO2 (52040)

- 잘못된 중복 제거로 데이터 손실 가능성

---

#### 프롬프트 #69: itemid별 개별 컬럼 유지 방안 선택 (16:12)

```

그러면 방안 1: itemid별 개별 컬럼 유지로 해서 진행한다.

```

**결정**: itemid 기준으로 개별 컬럼 유지

---

#### 프롬프트 #70: 중복 제거 오류 지적 (21:02)

```

아니 원래는 pCO2같이 50818, 52040같은 건 같은 label이지만 itemid가 달라서 달리 처리하기로 했는데

왜 이런 내용이 전혀 없는 거야?

지금 중간에 이런 내용 임의로 지우지 말고 전체가 다 나오도록 짜라고.

```

**문제 지적**: Claude가 임의로 데이터를 제거함

**요구**: 모든 항목 보존

---

#### 프롬프트 #71: itemid 기준 처리 원칙 확립 (21:24)

```

전체적으로 모든 항목을 처리할 때 itemid 기준으로 하고, label 기준으로 하지는 않는다.

이름 변경 등이 필요할 때는 label(itemid) 이런 형태로 처리하게 해서

잘못된 중복이라고 없어지는 일이 없게 한다.

```

**명확한 규칙**:

- **기준**: itemid (NOT label)

- **표기 형식**: `label(itemid)` 예: `pCO2(50818)`, `pCO2(52040)`

- **목적**: 데이터 손실 방지

---

#### 프롬프트 #72: 잘못된 분석 파일 삭제 (22:57)

```

좋았어. 그러면 이런 걸 기록하는 건 좋고,

아까 잘못한 내용들은 파일을 지우는 게 필요하다.

무슨 분석들을 잘못했었는지 생각해서 관련된 파일들을 모두 지워야 한다.

```

**목적**: 잘못된 분석 결과 제거

---

#### 프롬프트 #73: 파일 삭제 대신 wrong 접두사 추가 (24:03)

```

지운다고 하니 문제가 있을 것 같다.

파일 처음에 wrong이라는 내용을 붙여서 처리할 수 있게 한다.

```

**변경된 방침**:

- 삭제 ❌

- 파일명 앞에 `wrong_` 접두사 추가 ✅

- **이유**: 추적 가능성 유지

---

### Ch01-03. AI가 틀렸을 때 대처하기 - 처음부터 다시 시작

#### 프롬프트 #74: 새 폴더로 처음부터 재분석 (10:10)

```

지금 context가 너무 섞여서 보기가 불편한 것 같다.

analysis_initial_lab_re라는 폴더를 만들어서 지금 한 분석에 대해서 새로 시행하게 한다.

그리고 전반적인 내용은 포함하되 offset은 initial_lab.csv에 같이 포함되지 않도록 한다.

```

**전략**: 클린 스타트 (Clean Start)

- **새 폴더**: `analysis_initial_lab_re`

- **이유**: context 혼란 방지

- **조건**: offset 제외

---

### Ch01-04. Git 관리를 통한 버전 관리

#### 프롬프트 #75: 완료된 분석의 ipynb 예시 생성 (15:40)

```

분석을 지금 완료했는데 예시를 하나만 해서 ipynb로 만들어 줘.

```

**목적**: 분석 결과를 Jupyter Notebook으로 문서화

---

## 요약 통계

### 전체 프롬프트 개수

- **총 75개 프롬프트**

### 파트별 강의 구성

#### Part 1-3: 데이터 탐색 및 전처리 (프롬프트 1-34)

- 초기 설정 및 탐색: 6개 (프롬프트 1-6)

- Ch03-03 오류 재검토: 12개 (프롬프트 7-18)

- Ch01-01 Data Sampling: 2개 (프롬프트 16, 18)

- Ch01-02 Data Filtering: 3개 (프롬프트 19-21)

- Ch02-01 숨겨진 데이터 찾기: 9개 (프롬프트 22-30)

- Ch03-01 Missing Value 재평가: 4개 (프롬프트 31-34)

#### Part 4: 논문 재현 & 핵심 지표 분석 (프롬프트 35-58)

- Ch02-01 ICU별 입원 기간 그리기: 3개 (프롬프트 35-37)

- Ch02-02 사망자 데이터 정합성 평가: 2개 (프롬프트 38-39)

- Ch03-01 환자 Dataset 생성: 4개 (프롬프트 40-43)

- Ch03-02 예측 모델 개발: 8개 (프롬프트 44-51)

- Ch03-04 t-SNE 분석: 7개 (프롬프트 52-58)

#### Part 5: GPT API를 이용한 비정형 데이터 구조화 (프롬프트 59-61)

- Ch01-01 GPT API로 데이터 구조화: 2개 (프롬프트 59-60)

- Ch02-01 MIMIC-CXR LLM API 정제: 1개 (프롬프트 61)

#### Part 6: Claude Code의 약점을 보완하자 (프롬프트 65-75)

- Ch01-02 오류 수정 - Missing Value: 9개 (프롬프트 65-73)

- Ch01-03 AI가 틀렸을 때 대처하기: 1개 (프롬프트 74)

- Ch01-04 Git 버전 관리: 1개 (프롬프트 75)

### 프롬프트 유형별 분류

#### 1. 프로젝트 관리 (13개)

- 프롬프트 1, 3, 4, 13, 15, 17, 32, 37, 44, 45, 55, 72, 73

#### 2. 데이터 탐색 (12개)

- 프롬프트 2, 5, 7, 8, 19, 22, 23, 31, 33, 35, 36, 38

#### 3. 코드 작성/수정 (19개)

- 프롬프트 12, 16, 18, 20, 24, 25, 26, 27, 30, 34, 40, 42, 43, 46, 52, 57, 58, 60, 75

#### 4. 코드 이해 (8개)

- 프롬프트 9, 10, 21, 28, 41, 50, 51, 59

#### 5. 검증 및 오류 수정 (9개)

- 프롬프트 6, 11, 14, 29, 39, 47, 48, 49, 56

#### 6. 도구/형식 선택 (2개)

- 프롬프트 53, 54

#### 7. API/LLM 프롬프트 설계 (1개)

- 프롬프트 61

#### 8. 심층 분석 및 디버깅 (11개)

- 프롬프트 65, 66, 67, 68, 69, 70, 71, 74

- **특징**: deepthink, 근본 원인 분석, 데이터 손실 방지

---

## 핵심 학습 포인트

### 1. 체계적인 문서화

- claude.md를 활용한 중앙 집중식 문서 관리

- 파일 참조 및 라인 번호 명시

- 분석별 폴더 구조: `analysis_{name}`

### 2. 데이터 샘플링 전략

- 초기 탐색: 1만 건 샘플링

- 본 분석: 전체 데이터 사용 (샘플링 오류 발견 후)

- 계층적 샘플링: 사망자/생존자 비율 조정

### 3. 패키지 관리

- uv를 활용한 의존성 관리

- uv.lock으로 버전 고정

### 4. 데이터 전처리 원칙

- 결측치 유지 (입원이벤트 기준)

- 명확한 시간 기준 설정 (입원일자)

- 원본 데이터와 전처리 데이터 분리

### 5. Pandas 기법

- `shift()` 함수로 환자 이동 경로 추적

- `groupby()` + `shift()`로 이전 상태 참조

### 6. Missing Value 처리 전략

- 입원 당일 데이터만의 한계 인식

- 시간 윈도우 확장 (±1일)

- 우선순위 기반 데이터 채우기

- Missing value의 의미 재평가

### 7. 데이터 정합성 검증

- 병원 내/외 사망 데이터 불일치 확인

- 서로 다른 테이블 간 데이터 일관성 검증

- 불일치 환자 특징 분석

### 8. 예측 모델 데이터셋 구축

- 사망률 예측과 입원기간 예측을 위한 데이터 통합

- 입원기간 내 사망 vs 전체 사망 구분

- Missing value 기반 변수 선택

- 이전 분석 결과 재활용

### 9. 머신러닝 모델링 전략

- **시간 기반 교차 검증**: 과거 70% 학습, 최근 30% 검증

- **모델 순서**: 베이스라인 → 트리 모형

- **회귀 계수 해석**: 연속형 변수의 계수 의미 이해

- **한글 폰트 문제**: matplotlib 시각화 시 인코딩 이슈 해결

### 10. t-SNE 군집 분석

- 고차원 혈액검사 데이터의 2D 시각화

- 사망/생존, 성별, 입원 특성별 군집 탐색

- Jupyter Notebook 기반 인터랙티브 분석

### 11. GPT API를 활용한 비정형 데이터 처리

- 의료 리포트에서 구조화된 정보 추출

- JSON 형식으로 질병 정보 자동 분류

- 프롬프트 엔지니어링: 명확한 출력 형식 지정

### 12. AI의 오류를 발견하고 수정하기

- **itemid vs label 혼동**: 같은 이름이지만 다른 검사

- **데이터 손실 방지**: `label(itemid)` 표기법

- **파일 관리**: `wrong_` 접두사로 추적 가능성 유지

- **클린 스타트**: context 혼란 시 새 폴더로 재시작

---

## 블로그 시리즈 제안

### 시리즈 1: "Claude Code로 의료 데이터 분석 시작하기"

- 프로젝트 설정 (uv, 폴더 구조)

- MIMIC 데이터셋 소개

- 문서화 전략

### 시리즈 2: "데이터 샘플링의 함정과 해결"

- 1만 건 vs 5만 건 vs 전체 데이터

- 샘플링 검증 방법

- 계층적 샘플링 설계

### 시리즈 3: "입원 초기 검사 데이터 분석"

- 가장 흔한 검사 항목 선정

- 입원일 기준 데이터 병합

- 결측치 처리 전략

### 시리즈 4: "Pandas로 환자 이동 경로 추적하기"

- shift() 함수 완벽 이해

- groupby() 활용 패턴

- 시계열 데이터 전처리

### 시리즈 5: "시간 윈도우로 Missing Value 정복하기"

- 입원 당일 데이터의 한계

- 시간 윈도우 확장 전략 (±1일)

- 우선순위 기반 결측치 채우기

- 검사 항목별 Availability 분석 (상위/하위 10개)

### 시리즈 6: "ICU 데이터 분석과 데이터 정합성"

- ICU별 재원기간 시각화

- 샘플링된 데이터 vs 전체 데이터 구분

- 병원 내/외 사망 데이터 불일치 문제

- 데이터 정합성 검증 방법

### 시리즈 7: "예측 모델을 위한 데이터셋 구축하기"

- 사망률 예측 모델 데이터 준비

- 입원기간 예측 모델 데이터 준비

- 여러 분석 결과 통합하기

- Missing value 기반 변수 선택 전략

### 시리즈 8: "의료 데이터 예측 모델 개발 A to Z"

- 시간 기반 교차 검증의 필요성

- 베이스라인 모델 vs 트리 기반 모델

- 회귀 계수 해석하기 (연속형 변수 주의점)

- Jupyter Notebook 기반 실험 관리

- 한글 폰트 설정 및 시각화 팁

### 시리즈 9: "t-SNE로 환자 군집 발견하기"

- t-SNE 알고리즘 이해

- 혈액검사 데이터 전처리

- 사망/생존 그룹 시각화

- README.md로 분석 결과 문서화

### 시리즈 10: "GPT API로 의료 리포트 자동 분류하기"

- 비정형 텍스트 데이터의 도전

- GPT API 프롬프트 설계 전략

- JSON 형식으로 구조화된 출력 받기

- MIMIC-CXR 데이터셋 활용 사례

### 시리즈 11: "Claude가 틀렸을 때 - AI 오류 디버깅 실전"

- Missing Value 데이터 불일치 발견 과정

- itemid와 label의 차이 이해하기

- 데이터 손실 방지 전략: `label(itemid)` 표기법

- 임의 데이터 제거 문제 해결

- wrong_ 접두사로 실패 기록 남기기

- Context 혼란 시 클린 스타트 전략

- "deepthink"로 심층 분석 요청하기

---

## 발견된 이슈

### 타임코드 관련

- ✅ 프롬프트 1-14: 타임코드 미기재

- ⚠️ 프롬프트 16, 18: 동일 타임코드 (12:37) - 확인 필요

- ✅ 프롬프트 15-75: 타임코드 기재됨

### 강의 챕터 정보

- 프롬프트 1-6: 챕터 정보 없음 (초기 설정 단계로 추정)

- 프롬프트 7-18: Part 3, Ch03-03

- 프롬프트 16, 18-21: Part 3, Ch01 (Data Sampling & Filtering)

- 프롬프트 22-30: Part 3, Ch02-01 (숨겨진 데이터 찾기)

- 프롬프트 31-34: Part 3, Ch03-01 (Missing Value 재평가)

- 프롬프트 35-37: Part 4, Ch02-01 (ICU별 입원 기간)

- 프롬프트 38-39: Part 4, Ch02-02 (사망자 데이터 정합성)

- 프롬프트 40-43: Part 4, Ch03-01 (환자 Dataset 생성)

- 프롬프트 44-51: Part 4, Ch03-02 (예측 모델 개발)

- 프롬프트 52-58: Part 4, Ch03-04 (t-SNE 분석)

- 프롬프트 59-60: Part 5, Ch01-01 (GPT API 데이터 구조화)

- 프롬프트 61: Part 5, Ch02-01 (MIMIC-CXR LLM API)

- 프롬프트 65-73: Part 6, Ch01-02 (오류 수정 - Missing Value)

- 프롬프트 74: Part 6, Ch01-03 (AI가 틀렸을 때 대처하기)

- 프롬프트 75: Part 6, Ch01-04 (Git 버전 관리)

### 중복 프롬프트

- 순번 62-64는 순번 59-61과 동일한 내용으로 제외됨

---

## 핵심 개념 정리

### Part 3: 데이터 전처리 핵심 개념 (프롬프트 29-34)

### Missing Value의 진짜 의미

- **문제 발견**: 입원 당일 데이터만으로는 missing value를 정확히 평가할 수 없음

- **해결 방법**: 시간 윈도우 확장 (입원 전일 ~ 입원 1일째)

- **핵심 인사이트**: "데이터가 없다"와 "검사를 하지 않았다"는 다름

### 우선순위 기반 데이터 병합

```python

# 의사 코드

if 입원_당일_데이터_존재:

return 입원_당일_데이터

elif 입원_전일_데이터_존재:

return 입원_전일_데이터

else:

return 입원_1일째_데이터

```

### 검사 항목 Availability 분석

- 상위 10개: 가장 흔히 시행되는 검사

- 하위 10개: 특수한 경우에만 시행되는 검사

- **목적**: 검사별 missing value 패턴 이해

---

### Part 4: 실전 분석 핵심 개념 (프롬프트 35-43)

#### ICU 데이터 분석의 고려사항

- **샘플링 데이터 vs 전체 데이터**: ICU 분석 시 샘플링된 환자 기준으로 데이터 필요

- **폴더 구조 원칙**: 전체 데이터(`processed_data`)와 분석별 데이터(`analysis_*`) 명확히 구분

- **재원기간**: ICU별 입원 기간 시각화 및 비교

#### 데이터 정합성 검증의 중요성

```

병원 내 사망 vs 병원 외 사망

- 서로 다른 테이블에 사망 정보 존재

- 데이터 불일치 발생 가능

- 불일치 환자의 특징 분석 필요

```

**실무 교훈**: 의료 데이터는 여러 소스에서 수집되므로 항상 정합성 검증 필요

#### 예측 모델 데이터셋 구축 전략

**"deepthink!" 접근법**:

1. **데이터 통합**: 여러 분석 결과(`analysis_initial_lab_re`, `analysis_death01`) 결합

2. **변수 구분**: 입원기간 내 사망 vs 전체 사망

3. **변수 선택**: Missing value 분석 결과 활용

4. **재활용**: 이전 분석(`missing_value_analysis.md`) 참조하여 효율성 향상

**나이 계산 검증**:

- 계산식 기반 vs `anchor_age` 사용 여부 확인

- 데이터 생성 과정 투명성 확보

---

### Part 4 추가: 머신러닝 모델링 핵심 개념 (프롬프트 44-58)

#### 폴더 구조 관리의 중요성

- **문제 상황**: 프로젝트가 복잡해지면서 폴더 구조 혼란 발생

- **해결 방법**:

- 폴더 구조를 claude.md에 명시적으로 문서화

- 불확실한 사항은 사용자에게 먼저 보고

```

"지금 폴더 구성이 별로라 헷갈릴 것 같다"

→ 명확한 가이드 요청

```

#### 시간 기반 교차 검증 (Time-based Split)

```

과거 데이터 (70%) → 학습

최근 데이터 (30%) → 검증

```

**이유**: 의료 데이터는 시간 순서가 중요

- 미래 데이터로 학습 후 과거 데이터 예측 = 현실 불가능

- 과거로 학습 → 미래 예측이 실제 배포 시나리오

#### 회귀 계수 해석의 함정

**프롬프트 #51의 중요한 질문**:

```

"정상일수록 입원 기간 감소"라고 해석했는데,

정상/비정상으로 구분한 게 아닌 연속형 변수인데

이 해석이 맞나?

```

**교훈**:

- 연속형 변수: 값이 1 증가할 때의 효과

- 이분형 변수: 정상 vs 비정상 비교

- **혼동 주의!**

#### 실전 코딩 팁

**1. Jupyter Notebook vs Python 스크립트**

```

프롬프트 #53: "분석하는 건 py로 하지 말고 ipynb로 해서 좀"

```

- 분석: ipynb (시각화, 탐색)

- 파이프라인: py (재사용, 자동화)

**2. 한글 폰트 문제**

```python

# matplotlib에서 한글 깨짐 해결

import matplotlib.pyplot as plt

plt.rcParams['font.family'] = 'AppleGothic' # Mac

# 또는 'Malgun Gothic' (Windows)

```

**3. 파일 버전 관리**

```

프롬프트 #54-55: "가장 최신 버전이 뭐야?" → "나머지 파일은 지운다"

```

- 버전 관리 도구 없이 작업 시 명시적 정리 필요

#### t-SNE 분석 접근법

**목적**: 고차원 혈액검사 데이터를 2D로 시각화

- 군집 패턴 발견

- 사망/생존 그룹 분리도 확인

- 성별, 입원 특성별 차이 탐색

**문서화**: README.md에 모든 시각화 이미지 포함

---

### Part 5: GPT API 활용 핵심 개념 (프롬프트 59-61)

#### 코드 오류 분석 방법론

**프롬프트 #59의 접근**:

```

"이유를 잘 생각만 해봐. 코드는 고치지 말고."

```

**단계별 접근**:

1. **먼저 이해하기**: 왜 안 되는지 분석

2. **그 다음 수정**: 원인 파악 후 교정

**교훈**: 바로 고치지 말고 원인 분석 먼저!

#### GPT API 프롬프트 엔지니어링

**프롬프트 #61의 구조 분석**:

```json

{

"역할": "helpful assistant that recognize specific disease",

"입력": "{report} 의료 리포트",

"출력_형식": {

"pneumonia": "yes/no",

"tuberculosis": "yes/no",

"ILD": "yes/no"

}

}

```

**핵심 원칙**:

1. **명확한 역할 지정**: "helpful assistant that..."

2. **구체적인 작업**: "recognize specific disease from report as yes or no"

3. **엄격한 출력 형식**: JSON 스키마 제공

4. **이분 분류**: yes/no로 단순화

**실전 팁**:

- 출력 형식을 예시로 명시 → 구조화된 응답 보장

- 질병명 약어(ILD) 사용 → 토큰 절약

- yes/no 이분법 → 파싱 간편

---

### Part 6: AI 오류 디버깅 핵심 개념 (프롬프트 65-75)

#### 데이터 손실의 원인: itemid vs label 혼동

**문제 상황**:

```

pCO2 (itemid: 50818) ≠ pCO2 (itemid: 52040)

→ 같은 label이지만 서로 다른 검사!

```

**Claude의 실수**:

- label이 같으면 중복으로 판단

- itemid 무시하고 하나만 남김

- **결과**: 데이터 손실 발생

**해결책**:

```python

# 잘못된 방식

column_name = label # "pCO2"

# 올바른 방식

column_name = f"{label}({itemid})" # "pCO2(50818)", "pCO2(52040)"

```

#### deepthink: 심층 분석 요청 패턴

**프롬프트 #66**:

```

"왜 문제가 생긴 것인지 심도 있게 판단해 봐. deepthink."

```

**효과**:

- Claude가 단순 답변이 아닌 깊은 분석 수행

- 근본 원인 탐색

- 여러 가능성 고려

#### 파일 관리 전략: 삭제 vs wrong_ 접두사

**초기 제안**: 잘못된 파일 삭제

```bash

rm wrong_analysis.csv # ❌ 추적 불가

```

**개선된 방법**: wrong_ 접두사

```bash

mv analysis.csv wrong_analysis.csv # ✅ 추적 가능

```

**장점**:

1. **추적 가능성**: 무엇이 잘못되었는지 확인 가능

2. **되돌리기 가능**: 실수 발견 시 복구 가능

3. **학습 자료**: 실패 사례 보존

#### Context 혼란 시 클린 스타트

**프롬프트 #74의 전략**:

```

"context가 너무 섞여서 보기가 불편한 것 같다"

→ analysis_initial_lab_re 폴더 생성

```

**클린 스타트 시점**:

- Context가 너무 길어졌을 때

- 이전 오류가 계속 영향을 미칠 때

- 새로운 접근법이 필요할 때

**방법**:

1. 새 폴더 생성 (`_re`, `_v2` 등)

2. 핵심 설정만 복사

3. 처음부터 다시 시작

#### AI 오류 발견과 수정 프로세스

```

1. 문제 인식

↓

2. 심층 분석 (deepthink)

↓

3. 근본 원인 파악

↓

4. 명확한 규칙 수립 (itemid 기준 등)

↓

5. 잘못된 결과 표시 (wrong_)

↓

6. 클린 스타트로 재분석

```

**교훈**:

- **AI도 실수함**: 임의로 데이터 제거 가능

- **명확한 규칙 필요**: itemid vs label 같은 세부 사항 명시

- **추적 가능성**: wrong_ 접두사로 실패 기록

- **과감한 재시작**: context 혼란 시 새로 시작

---

## 프롬프트 작성 패턴 분석

### 효과적인 프롬프트 특징

1. **명확한 저장 위치 지정**

- 예: "analysis_prediction01라는 폴더에 저장"

- 예: "processed_data는 바깥에 있는 내용으로 추가"

2. **이전 분석 참조**

- 예: "@analysis_initial_lab/missing_value_analysis.md 여기에서 이미 분석이 되어 있다"

- 재활용을 통한 효율성 향상

3. **심도 있는 계획 요청**

- 예: "깊게 생각하고 플랜을 짜라"

- 예: "deepthink!"

- Claude가 더 상세한 계획을 수립하도록 유도

4. **구체적인 데이터 요구사항**

- 예: "입원기간 내 사망인지, 전체 사망인지 확인 및 구분이 필요하다"

- 모호함 제거

5. **새 세션 시작 명시**

- 예: "새 클로드 실행"

- 컨텍스트 초기화 필요성 인지

6. **단계별 접근 요청**

- 예: "이유를 잘 생각만 해봐. 코드는 고치지 말고." (프롬프트 #59)

- 분석 → 수정의 순서 명시

7. **조건부 의사결정 위임**

- 예: "nbconvert를 설치해서 하는 게 더 나으면 그렇게 한다" (프롬프트 #49)

- Claude의 판단에 맡기는 유연성

8. **확인 및 보고 요청**

- 예: "불분명한 게 있으면 반드시 나에게 보고하고 진행한다" (프롬프트 #45)

- Claude가 독단적으로 진행하지 않도록 제어

---

## 학습 여정 요약

### 데이터 탐색 → 전처리 → 모델링 → 실전 활용 → 오류 수정

**1단계: 기초 다지기 (프롬프트 1-34)**

- 프로젝트 구조 설계

- 데이터 탐색 및 이해

- Missing value 처리 전략

**2단계: 실전 분석 (프롬프트 35-58)**

- ICU 데이터 분석

- 예측 모델 개발

- 고급 시각화 (t-SNE)

**3단계: AI 활용 (프롬프트 59-61)**

- GPT API로 비정형 데이터 처리

- 의료 텍스트 자동 분류

**4단계: AI 디버깅 (프롬프트 65-75)** ⭐ NEW!

- Claude의 실수 발견 (itemid vs label)

- 데이터 손실 방지 전략

- Context 혼란 시 클린 스타트

- 실패 기록 관리 (wrong_ 접두사)

### 강의의 핵심 메시지

1. **체계적인 문서화**: claude.md 중심의 프로젝트 관리

2. **점진적 개선**: 오류 발견 → 수정 → 재분석의 반복

3. **실무 중심**: 실제 의료 데이터의 복잡성 직면

4. **도구 활용**: Claude Code + GPT API 시너지

5. **AI도 실수함**: 명확한 규칙과 검증 필수 ⭐ NEW!

---

**최종 업데이트**: 2025-12-20

**데이터 출처**: 바이브코딩 의료 데이터 분석 강의

**총 프롬프트 수**: 75개 (중복 제외 시 72개, 순번 62-64 제외)

**강의 구성**: Part 1-6 (초기 설정 → 전처리 → 모델링 → GPT API → AI 디버깅)

**최신 챕터**: Part 6, Ch01-04. Git 관리를 통한 버전 관리

**주요 분석 목표**:

- 사망률 예측 모델 구축

- 입원기간 예측 모델 구축

- GPT API를 활용한 의료 텍스트 자동 분류

- AI 오류 발견 및 수정 (itemid vs label 문제)

728x90

'FastCampus' 카테고리의 다른 글

| 외주 개발 바이블 : Cursor AI로 시작하는 프리랜서 실전 패키지-Part 11. Cursor AI로 인터랙티브 반응형 웹 만들기 (3) | 2025.12.21 |

|---|---|

| 스포츠에 마케팅을 입히다! 재미있는 스포츠 마케팅 이야기 -1 (0) | 2025.12.20 |

| 어쩌다 팀장: 신임팀장을 위한 원포인트 리더십 레슨 (0) | 2025.12.13 |

| LLM 시대, 테스트 자동화는 어디까지 왔을까? (0) | 2025.12.13 |

| 디지털 시대, 스마트한 일잘러의 핵심 역량 6 - 1창의성 (0) | 2025.11.02 |